前幾個禮拜 ChatGPT 推出了 Advanced Voice Mode,讓我們可以透過更自然的對話方式來跟 ChatGPT 詢問問題,而後續也推出了對應的 Readtime Api ,可以讓我們透過程式來建置出屬於自己的 Realtime 的應用程式,而在 Azure 上面當然也提供了這個模型,一樣來測試看看吧。

說明

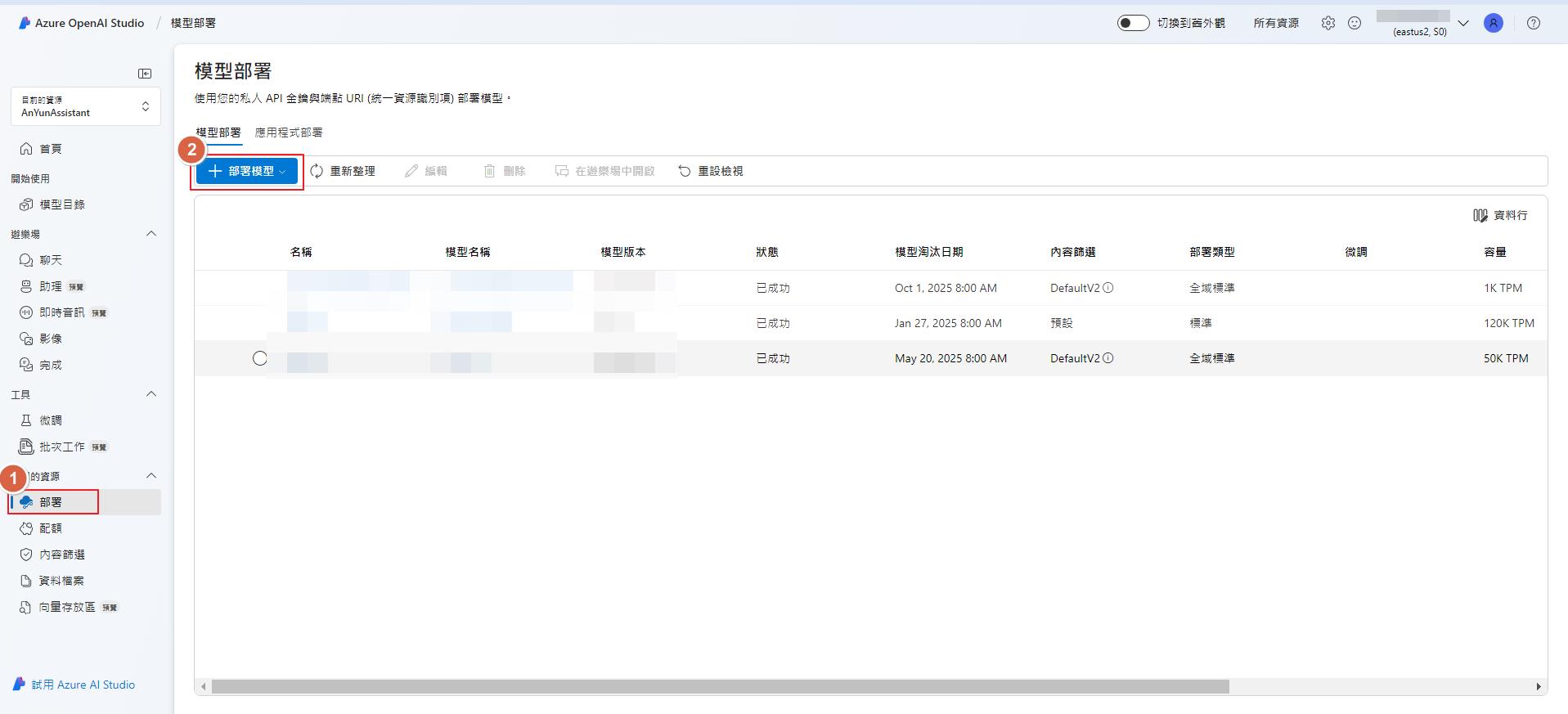

一樣開啟 OpenAI Studio 來部署模型。

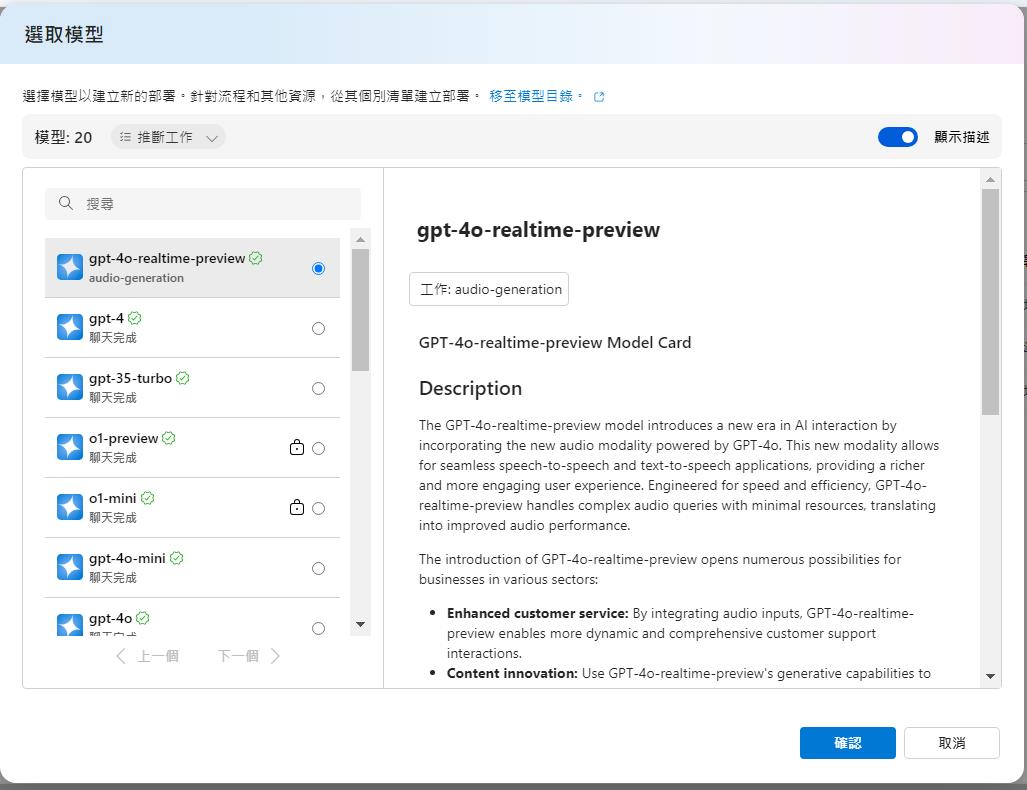

可以找到 gpt-4o-realtime-preview 這一個模型,點選來部署。

目前要注意的是只支援 East US2 和 Sweden Central 這兩個資料中心。

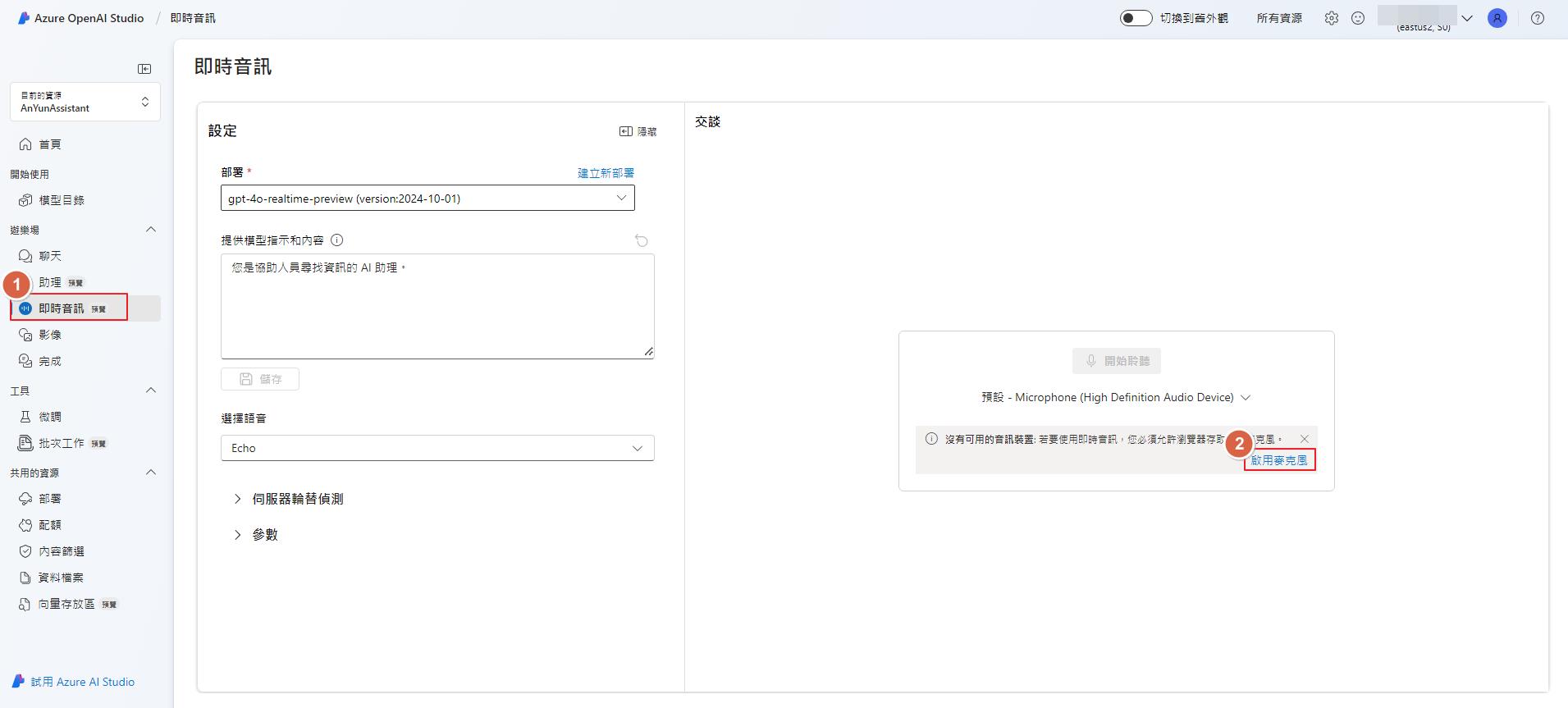

部署好之後可以在即時音訊來測試看看,如果還沒授權瀏覽器可以存取麥克風的話,就會需要點一下啟用麥克風,如果有授權過的就可以點選開始聆聽來測試囉。

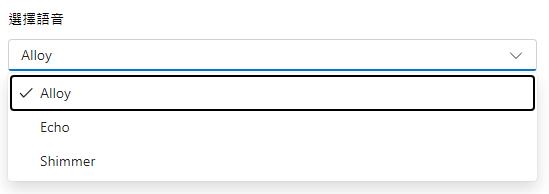

而在語音的部分會有三個可以選擇。

底下的我簡單錄製的 Demo,因為設備關係沒辦法錄製到我問問題的聲音,但是還是可以體驗一下這個模型的結果,我詢問的是台灣的美食,並且在他回覆的過程中斷,並請他推薦剛剛回覆中的其中一樣美食,從影片中就可以看到它是可以接受中斷的。

而如果要透過 API 來串接的話,可以參考官方的 GitHub,我也錄製了一個簡單的範例來展示一下結果。

結論

現在生成式 AI 發展越來越快,之前還得透過文字來對模型下指令,或是最多是額外可以透過語音辨識來跟模型下指令,現在我們可以像一般對話一樣來跟 AI 模型對話,讓使用上變的越來越方便了,而要透過程式來開發自己的即時對話的應用程式也變的很方便,在應用上就可以開發像是客服助理、翻譯助理等,之後如果可以同時支援 Function 或是影像辨識等,就可以在一個模型做掉所有的事情,就不用還要判斷是否要利用其他特定的模型來產生圖片或是辨識圖片等,期待接下來的發展了。