Windows 2008 R2 Failover Clustering 建立初探

0. 環境介紹

a. AD Server + Storage Server (簡稱Storage Server)

OS : Windows 2008 Server R2 (64bit)

b. Node 1

OS : Windows 2008 Server R2 (64bit)

c. Node 2

OS : Windows 2008 Server R2 (64bit)

d. Test Client

OS : Windows 2008 Server R2 (64bit)

帳號介紹

ID : Test1 , Test2

權限設定

TestGroup1 : Test1

TestGroup2: Test2

注意事項 :

原本在叢集伺服器上需要安裝"私人活動訊號"(private "Heartbeat"),但官方說明若在Windows Server 2008上安裝則不需要。

1. 建立Storage

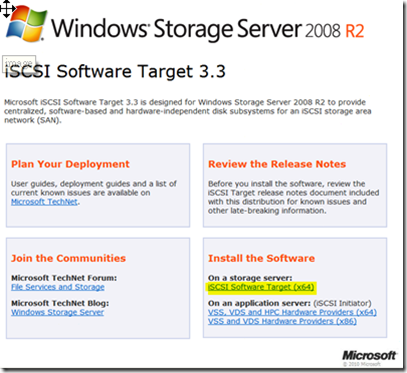

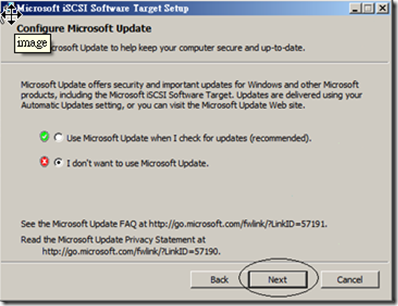

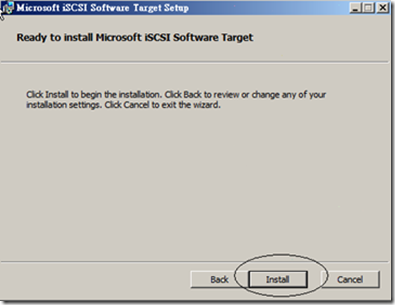

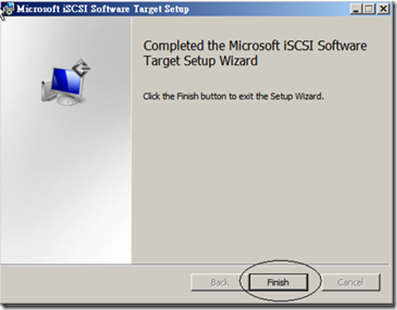

首先你需要去下載"Microsoft iSCSI Software Target 3.3"

參考資料 http://207.46.16.252/zh-tw/library/gg232606(en-us,WS.10).aspx

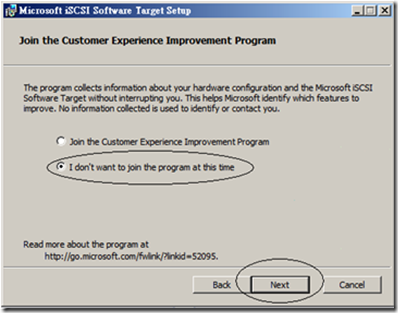

在Stirage Server 安裝 "Microsoft iSCSI Software Target 3.3",過程如下

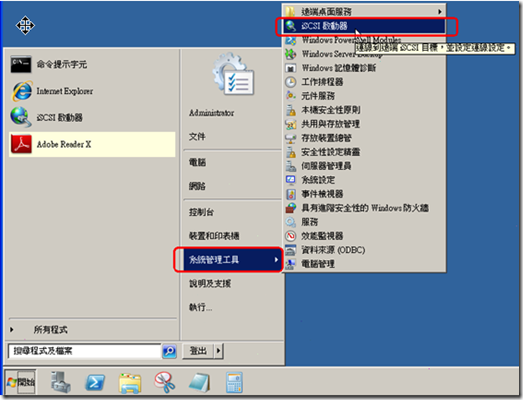

2. 在各Node設定iSCSI啟動器,設定Target to Storage Server

由於我們測試案例有兩個Node,所以每個Node都須設定一次,共兩次。

先點擊"iSCSI啟動器"",如下圖

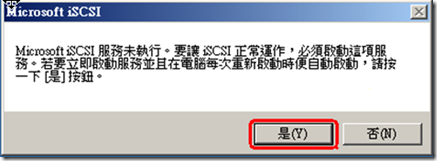

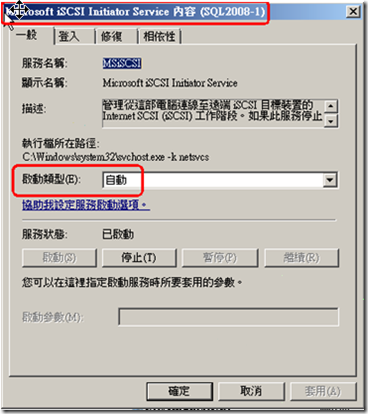

設定服務,讓每次電腦啟動時便會自動啟動

設定完成後,可至Service查詢”Microsoft iSCSI Initiator Service”即可發現,已經設定為"自動"啟動。

接下來,就要將Storage Server設定為我們探索的目標,這樣一來Storage Server就可以看到本台Server,之後才可以進行後續設定 。

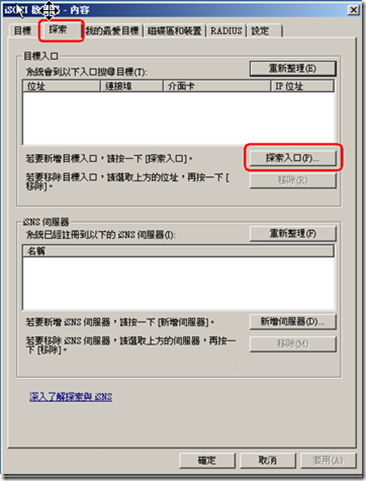

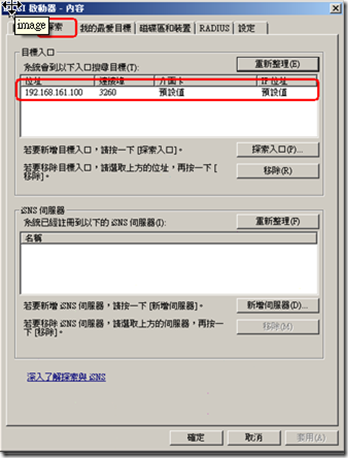

首先,點擊"探索"頁簽,然後點擊"探索入口"。

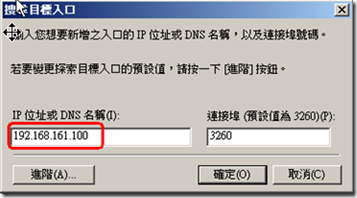

再將Storage Server的IP or DNS Name打入。

預設的Port是3260,若Stirage Server 有更改,此處必須更改。

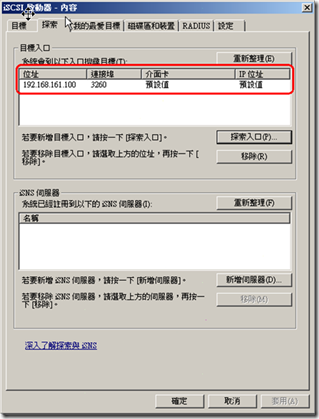

設定完成後就會看到Storage Server已經在本基的”目標入口”中。

備註:

根據網路上前輩的經驗,有提到需確認防火牆允許此Port進出,這聽起來也合乎道理,但根據個人經驗,似乎不用設定也可以運作,但是仍是設定好較為保險。

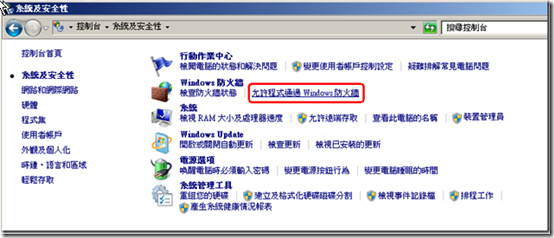

從"控制台",點擊"系統及安全性",會出現下圖視窗,再點擊"允許通過Windows防火牆"

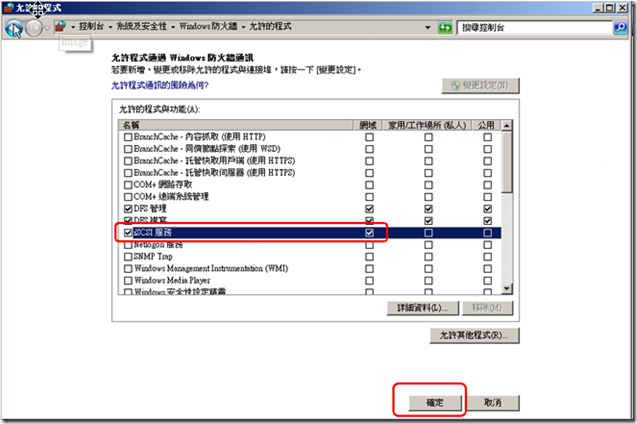

尋找"iSCSI服務",並且將其打勾,最後按下確定即可。

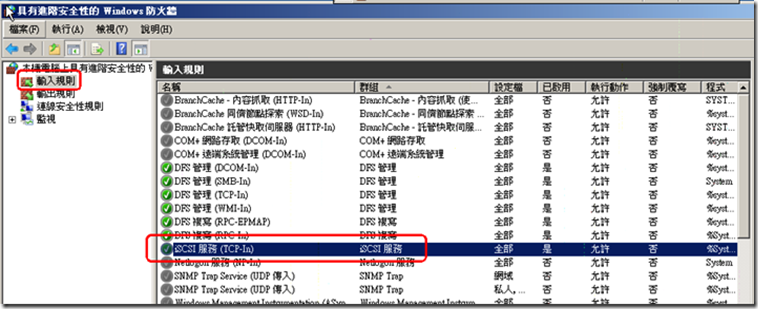

安全起見,進到"系統及安全性"視窗,再點擊"查詢防火牆狀態",點擊"進階設定"

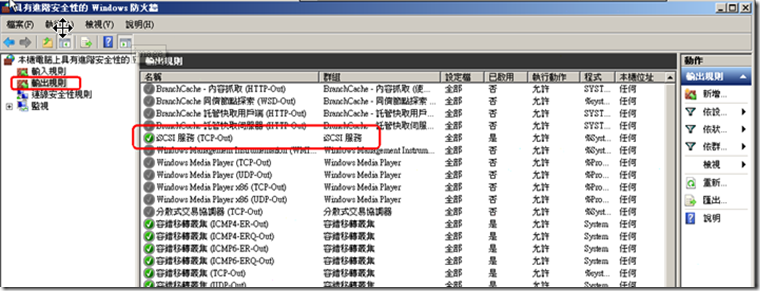

分別在"輸入規則" 與 "輸入規則"中,啟動iSCSI(TCP-In)與iSCSI(TCP-Out)。兩者圖示分示如下。

記得,Node 1 & Node 2都要做相同的設定。

當所有的Node都做完時,我們就設定好Node 端與Storage端iSCSI的連接。接下來就要到Storage Server去設定Storage了。

3.建立叢集所需要的Space

接下來,我們登入到Storage Server中,進行Storage設定。

a. 仲裁磁碟(quorum disk)

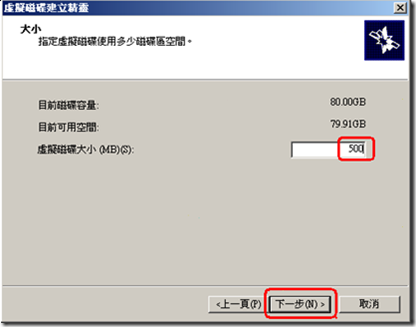

根據MSDN官方資料顯示,仲裁磁碟將儲存容錯叢集的組態資料,只需約500M即可。

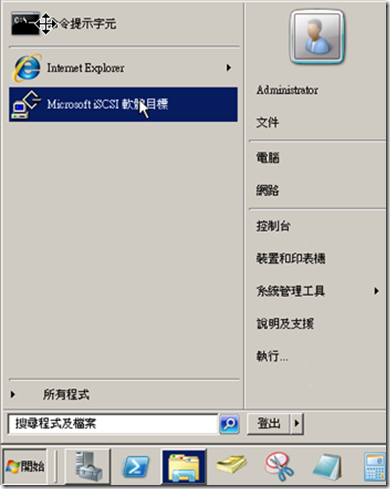

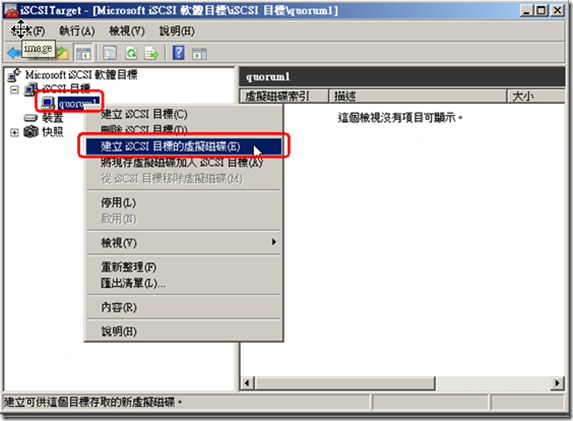

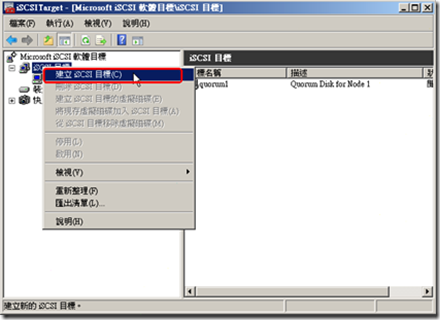

收先點擊"Microsoft iSCSI 軟體目標"。

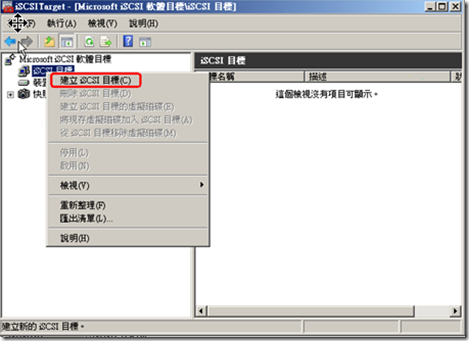

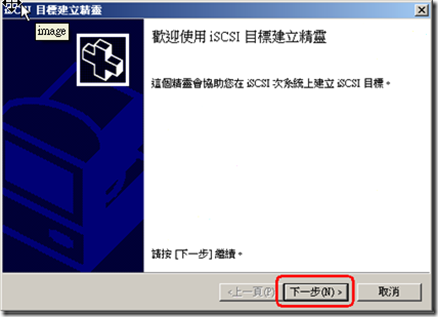

對"iSCSI目標"點右鍵,並點擊"建立iSCSI目標"。

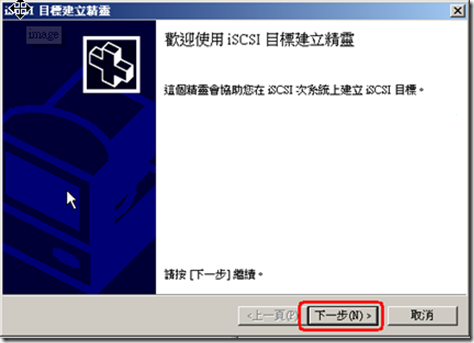

點擊"下一步"。

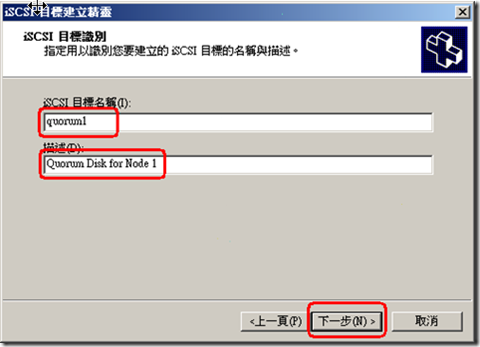

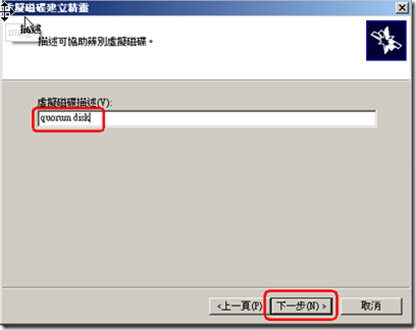

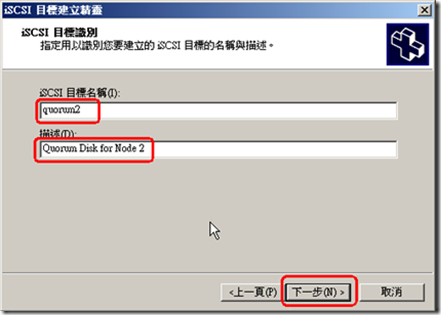

由於我們在建立"仲裁磁碟"(quorum disk),且我們要分別為所有Node建立"iSCSI目標"。

根據本案例,我們要建立兩個。

第一個,我們在名稱輸入"quorum1",並在描述中寫明"Quorum Disk for Node 1"。

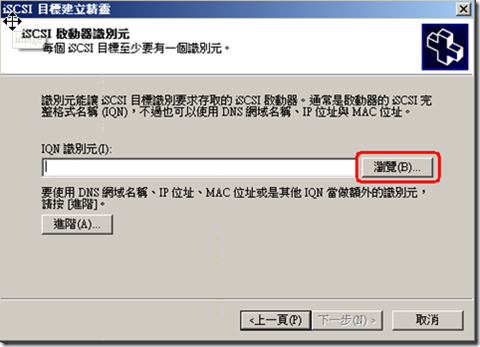

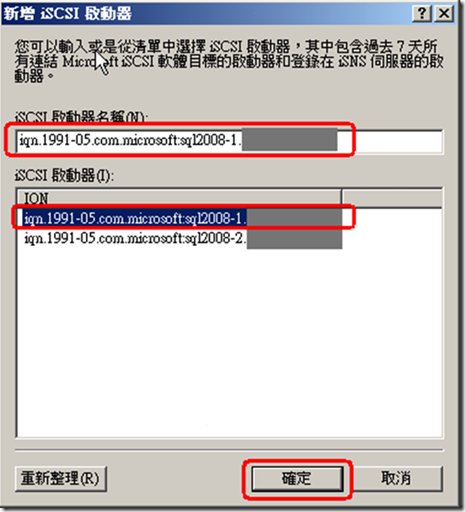

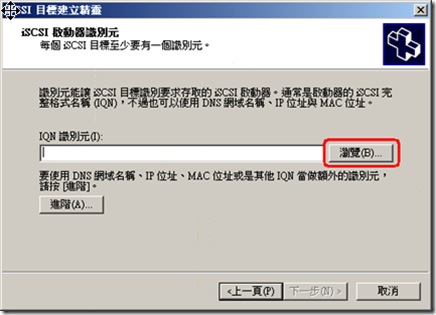

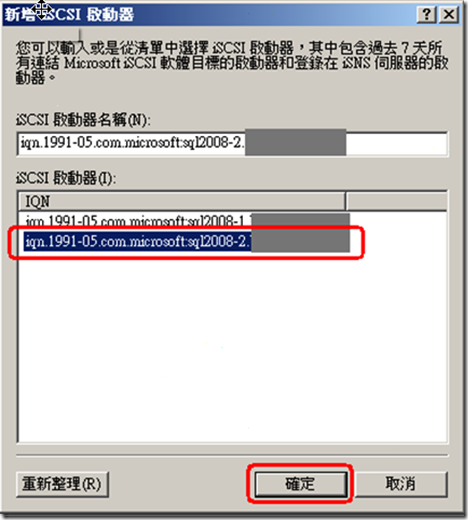

接下來再,要設定IQN識別元,點擊"瀏覽"按鈕。

這時候,我們在Node的"iSCSI啟動器"中建立的IQN就可以在此看到。所以我們可以按看到兩個IQN,連接到兩個Node。

由於這是針對Node1設定,所以請選擇Node1的IQN,並按下確定。

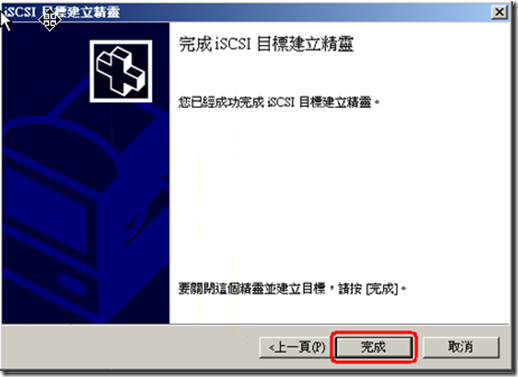

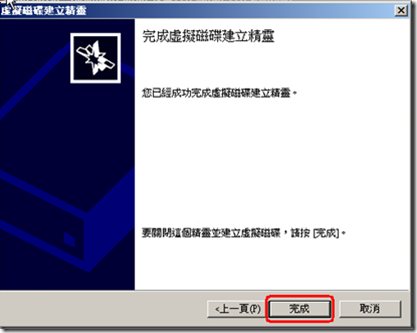

並按下"完成"。

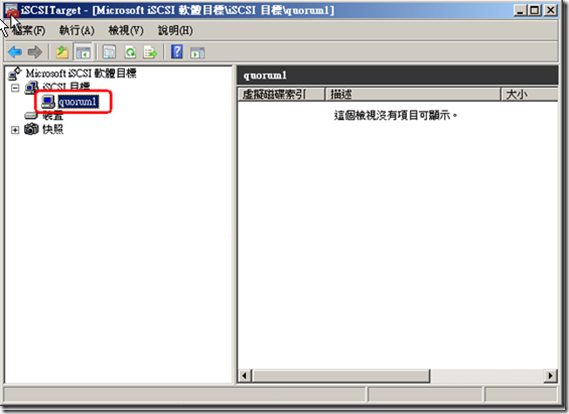

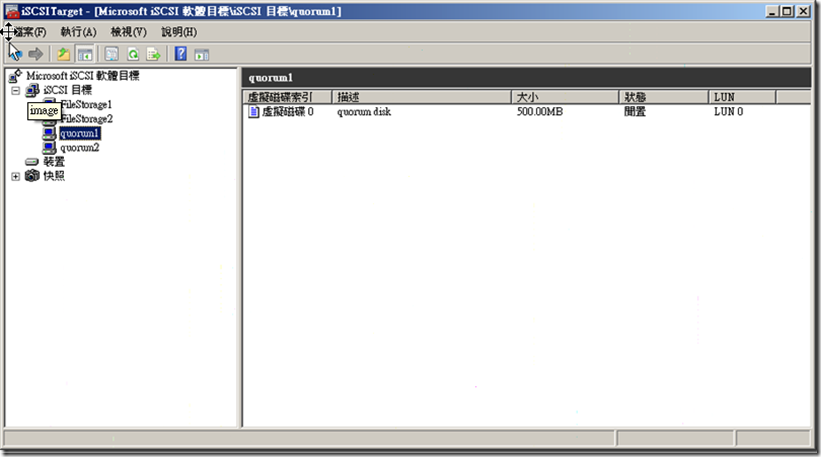

設定完後,可以在iSCSI Target中看到我們設定的"quorum1”。

接下來,要將磁碟設定到該iSCSI目標中。

由於沒有事先準備,因此直接用"建立iSCSI目標的虛擬磁碟"。

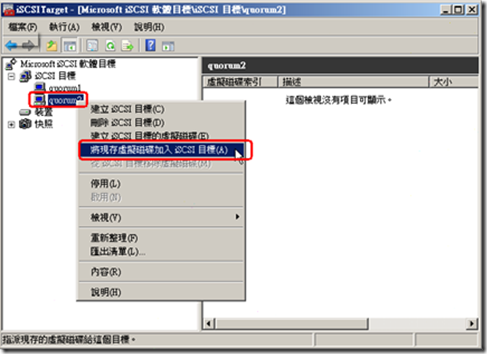

如果各位看官已有磁碟可以用"將現存虛擬磁碟加入iSCSI"的方式加入。

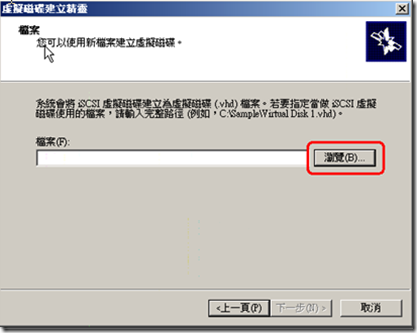

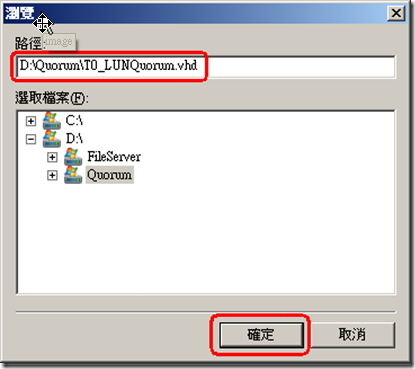

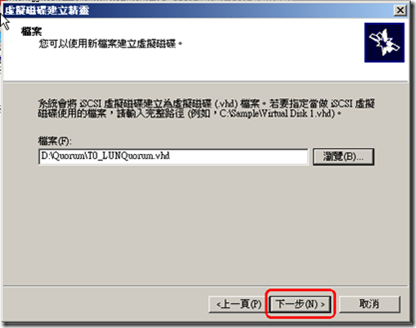

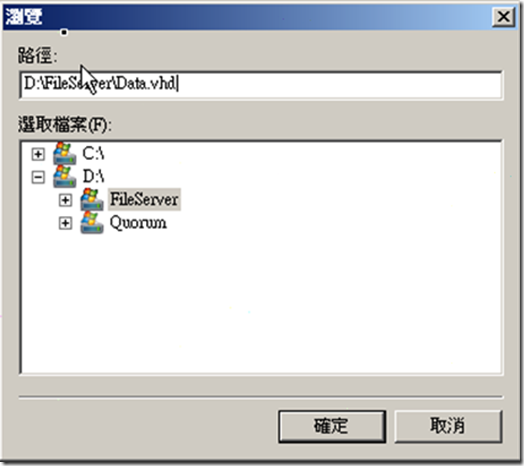

接下來,輸入新的虛擬磁碟路徑與檔名,並指定磁碟大小與磁碟描述,最後讓系統幫我們建立。

過程如下:

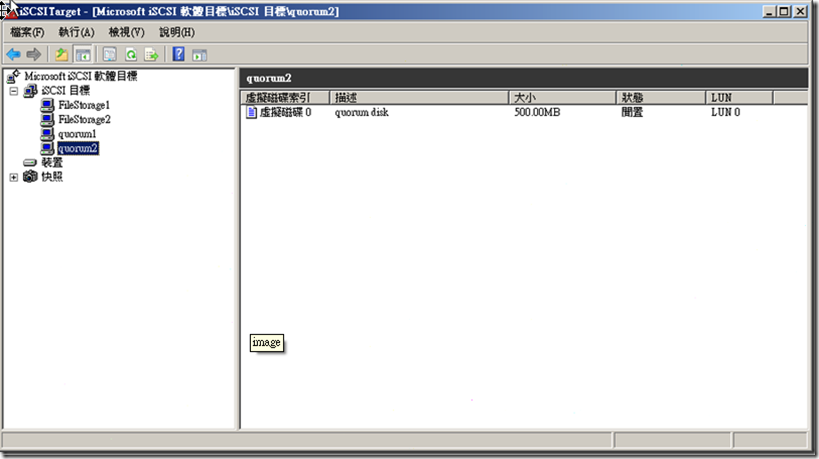

接下來,我們為Node 2建立Quorum Disk的iSCSI目標。

由於我們是為Node 2建立,因此這邊要選Node 2的IQN。

再者,由於虛擬磁碟(要共用)已經於Node1時建立完成,這邊我們就選"將現存虛擬磁碟加入iSCSI"的方式加入。

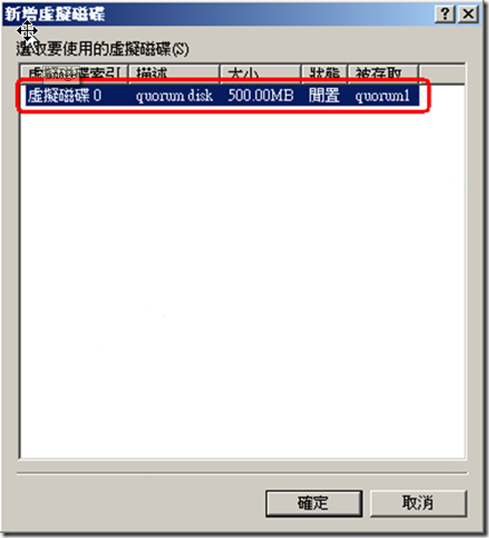

選擇剛剛在Node 1建立的"quorum disk"。

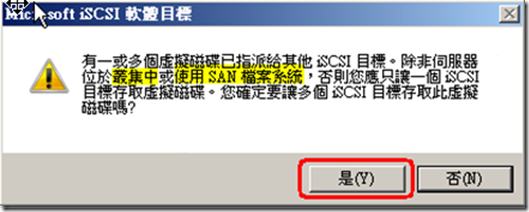

這時系統會因為兩個IQN都連到同一個虛擬磁碟,因而提出警告,但這正是我們的目的,所以按下"是"即可。

b. 資料磁碟

接下來建立資料磁碟,空間大小為50G。

由於步驟與a相同,差別在於名稱與說明的內容改變,就不逐一貼圖,請參照a.的方式進行即可。

一樣的我們要為兩個Node分別建立iSCSI目標,同時也要連接到同一個虛擬磁碟中。

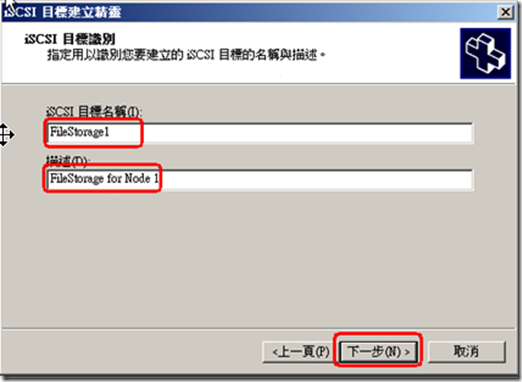

以下是片段的設定畫面,因為過程都一樣,只是因建立的標的不同文字略有差異,故不贅述。

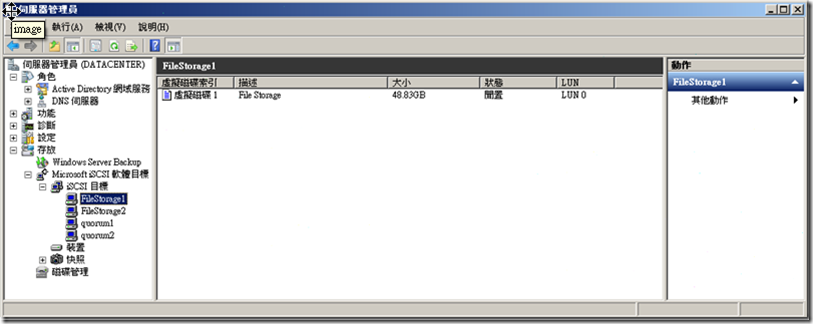

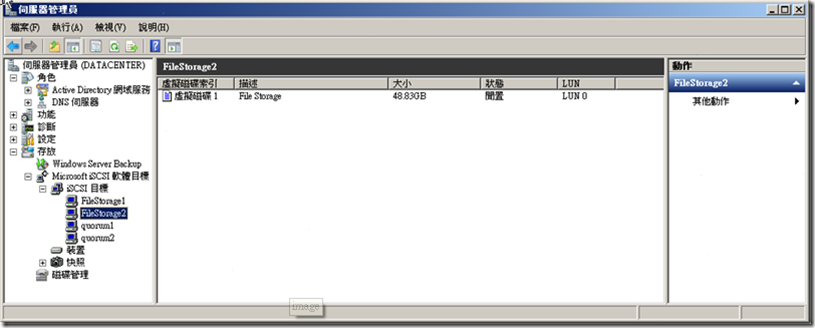

iSCSI目標的設定

建立虛擬目錄中的"路徑與檔案名稱"

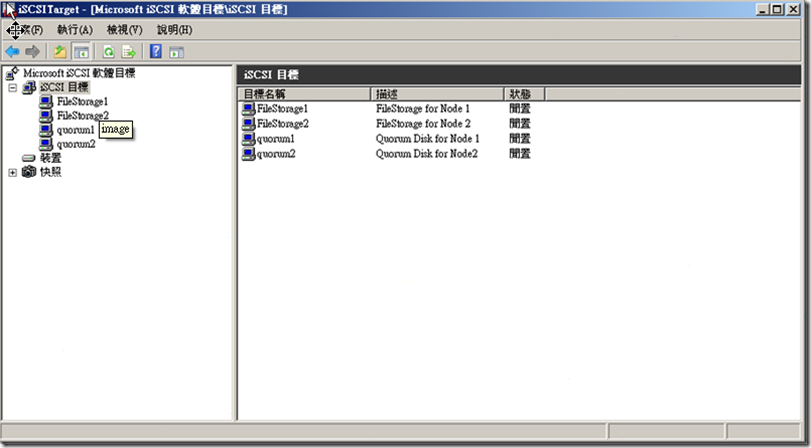

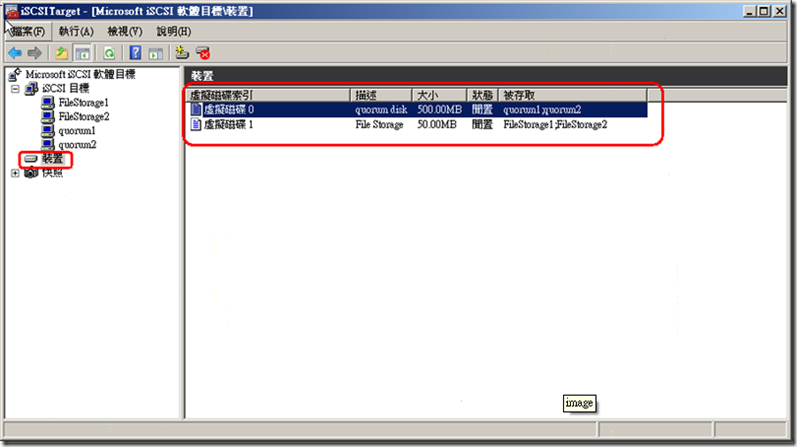

c. 總檢查

好了!這樣我們也將Storage設定完成。

就讓我們進行總檢查吧!

我們一共建立了四個iSCSI目標

FileStorage1 連接到Node1 , 連接到虛擬磁碟 File Storage。

FileStorage2 連接到Node2 , 連接到虛擬磁碟 File Storage。

quorum1 連接到Node1 , 連接到虛擬磁碟 quorum disk。

quorum2 連接到Node2 , 連接到虛擬磁碟 quorum disk。

我們建立了兩個虛擬磁碟,分別為quorum disk 與File Storage。

3.將各Node建立iSCSI 磁碟

由於在上面步驟已經將Stoarge設定完成。

接下來,我們就開始真正的將各Node的iSCSI連接到Storage中。

a. 在Node 中建立 quorum Disk

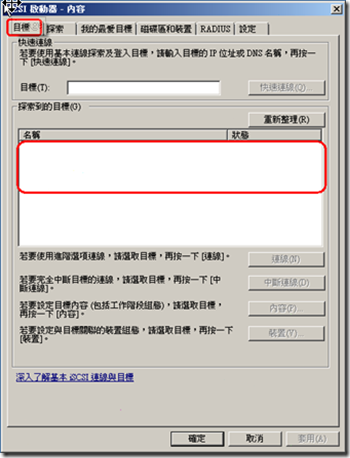

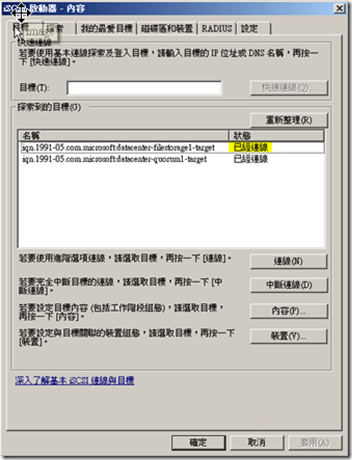

首先登入到Node Server 1中,並啟動"iSCSI啟動器"。

再次提醒,我們之前已經將Storage的IP or DNS Name設定到探索中,因此,Storage Server才看的到我們。

一進入時,在目標頁簽中"探索到的目標"是空的。

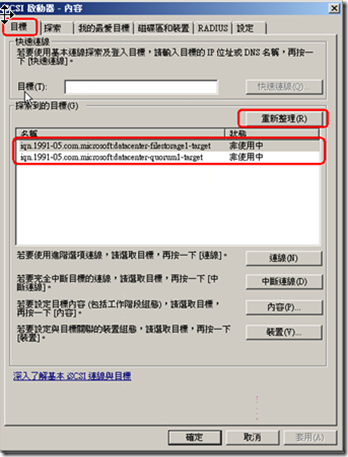

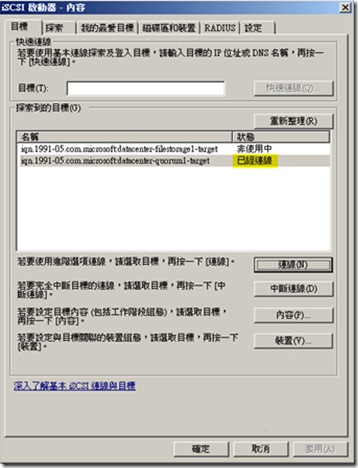

接下來,按下"重新整理"按鈕,就會我們在Storage Server 中為Node 1所建立的iSCSI 目標 。

總共有兩個iSCSI目標Disk,一個為quorom ,另一個為FileStorage。

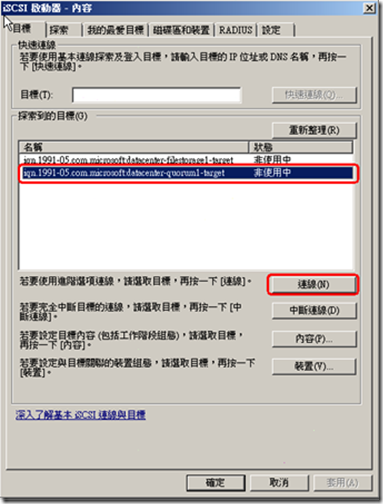

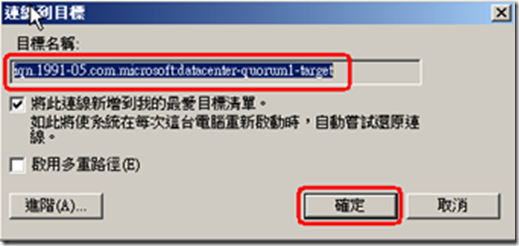

啟動quorum disk連線。

步驟如下:

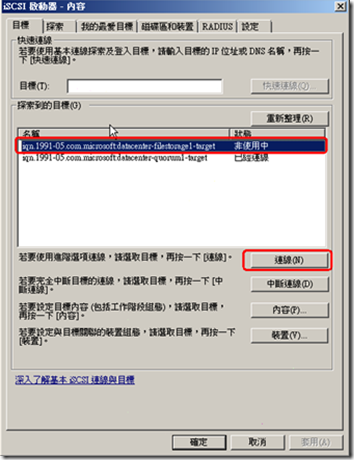

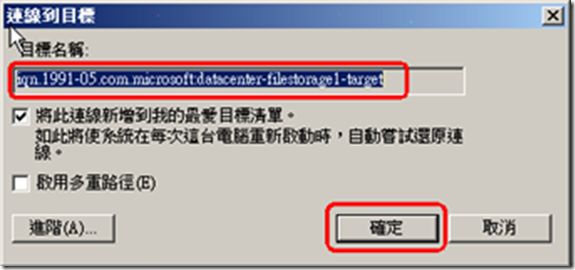

啟動File Storage disk連線。

步驟如下:

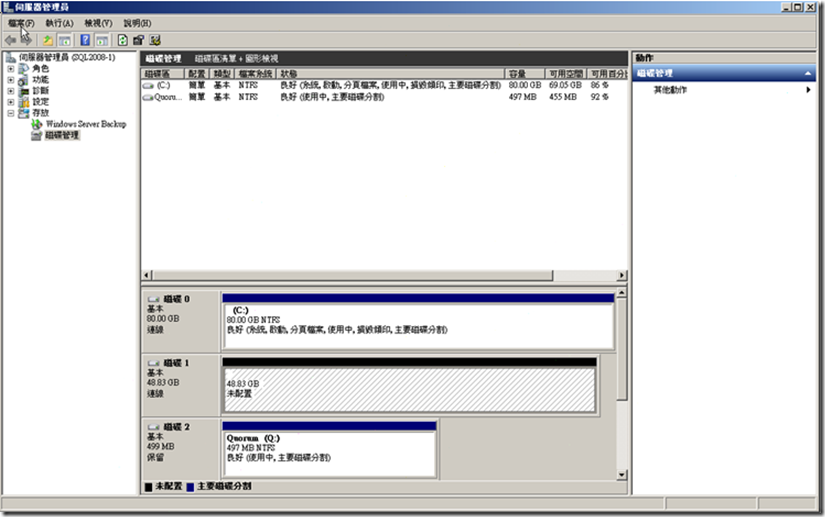

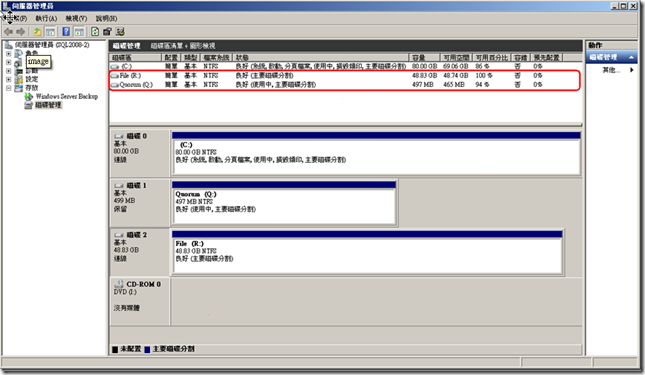

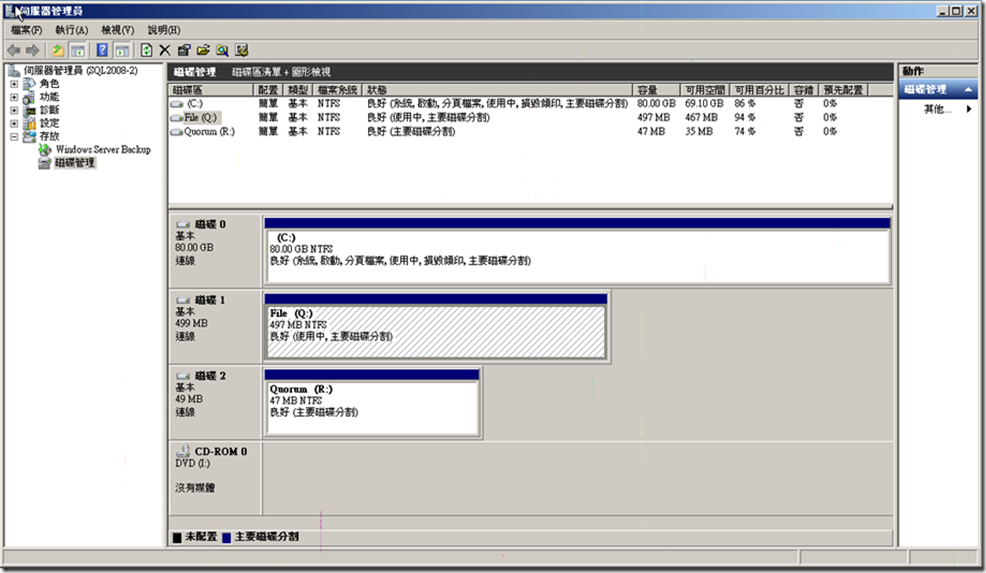

接下來,進入"磁碟管理"中,連線上的這兩個硬碟,在此都可以看到。

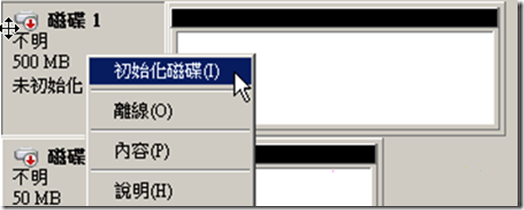

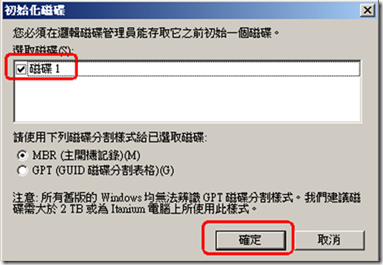

但是,都顯示"離線狀態",因此我們需要將其"連線",並做"初始化",並將其製作"簡單磁碟區",最後將其格式化後完成所有動作。

相關操作圖片如下:

在"磁碟1"上點擊右鍵,並將其"連接"與"初始化磁碟"。

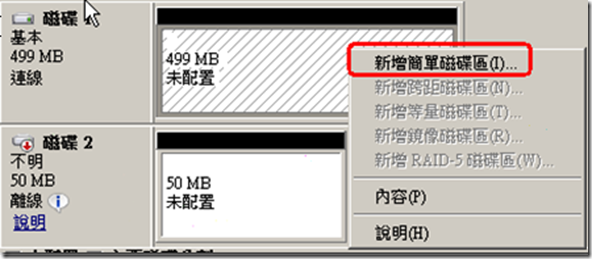

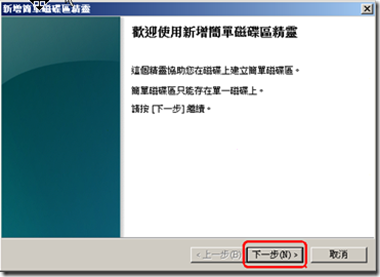

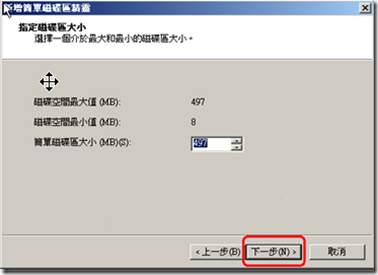

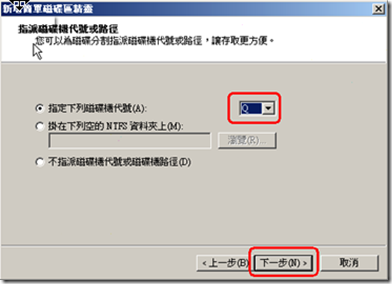

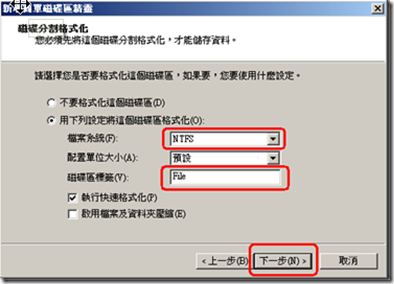

初始化後,硬碟處於未配置階段,我們在"未配置"上點右鍵,點擊"新稱簡單磁碟區"。

兩個Node都一樣,

我們將quorum 磁碟代號為Q

我們將File Storage 磁碟代號為R

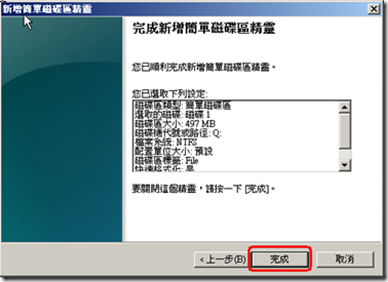

當我們對兩個磁碟都做完設定時,就可以得到以下的畫面。

讓我們再來看看,

quorum 磁碟代號為Q,磁碟大小約500M。

File Storage 磁碟代號為R,磁碟大小約50G。

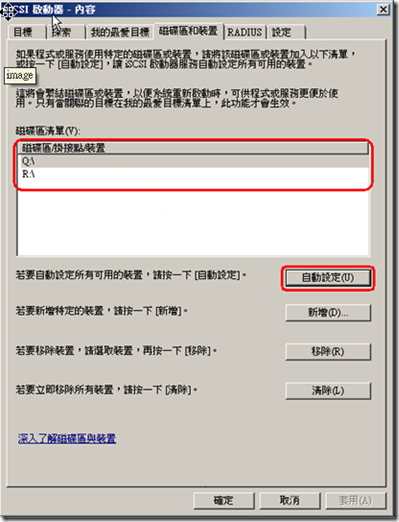

這時,開啟iSCSI啟動器,在"磁碟區和裝置"頁簽中,點擊"自動設定"就會在"磁碟區清單"中看到我們剛剛的設定。

由於我們在Node 1中已將磁碟給初始化與格式化了,因此在設定Node 2時,只要將磁碟狀態連線上,就可以了。

但是,要更改磁碟代號喔!

quorum 磁碟代號為Q,磁碟大小約500M。

File Storage 磁碟代號為R,磁碟大小約50G。

到現在為止,我們將各Node都連接到iSCSI Disk了,同時也將磁碟代號都統一設好。

接下來才是進行"容錯叢集的建立"作業。

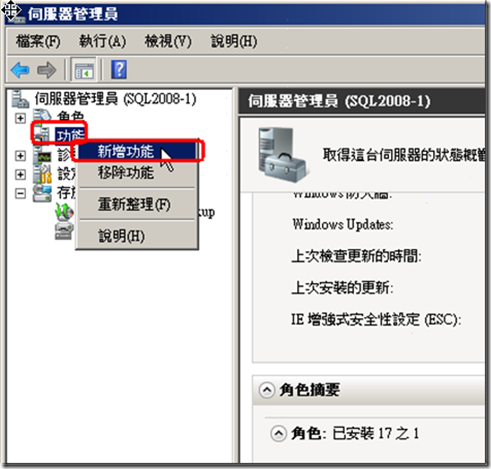

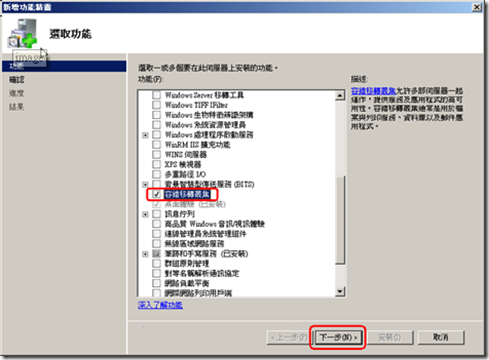

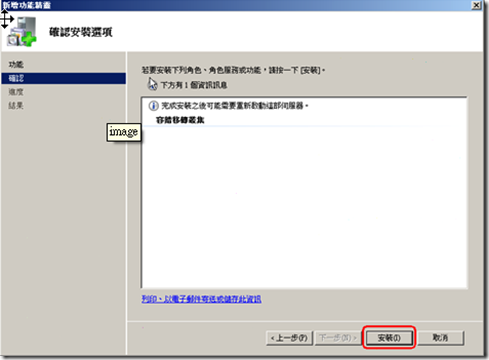

4.建立容錯叢集

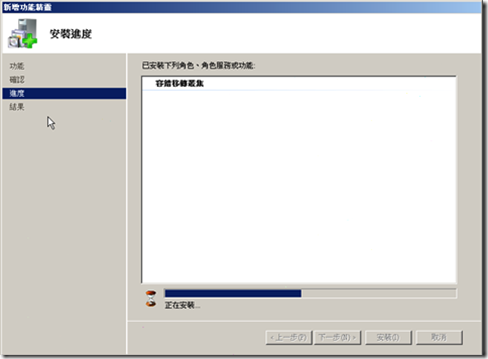

由於我們是要將兩個Node 做成容錯叢集,因此兩個Node都要新增 "容錯移轉叢集"的功能。

增加此功能的步驟如下顯示:

別忘了,Node 2 也一樣安裝" 容錯移轉叢集”的功能。

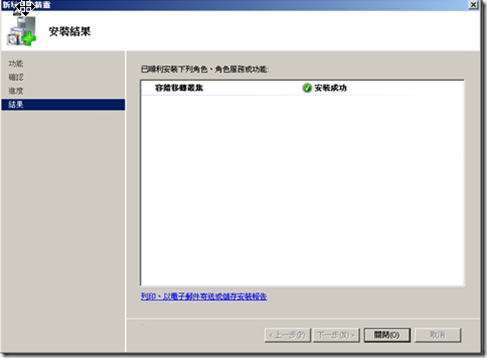

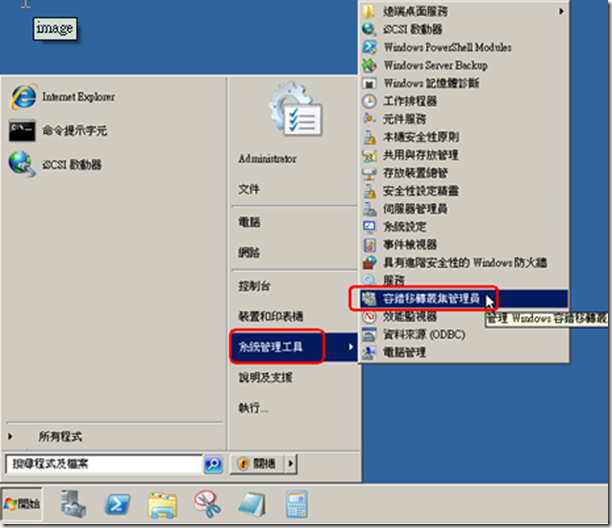

接下來,我們就正式要建立"容錯移轉叢集"了。

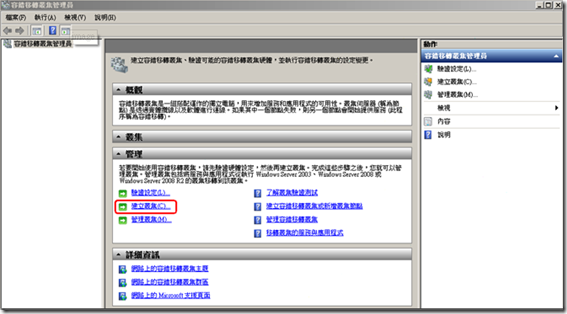

進到Node1中,點擊"系統管理工具",點擊"容錯移轉叢及管理員"。

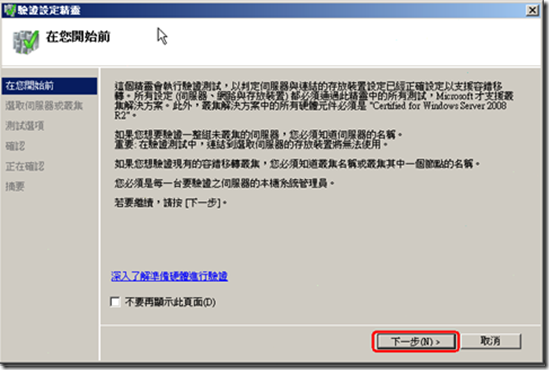

為了確保者兩節點建立叢集沒有問題,我們需要先用系統功能進行"驗證"。

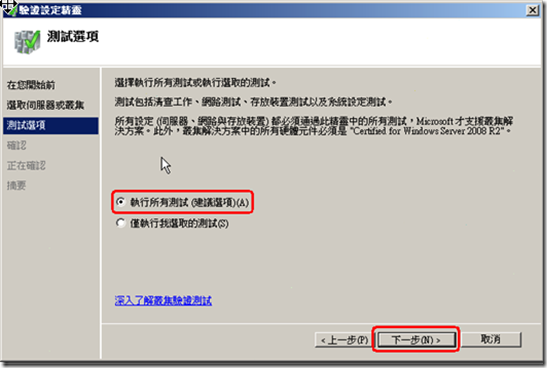

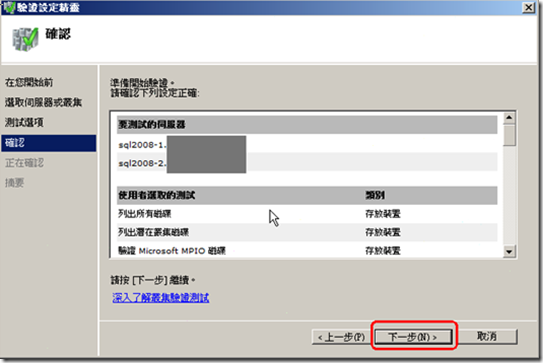

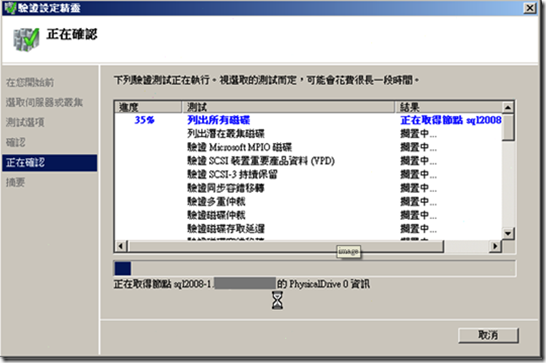

驗證的操作步驟,顯示如下:

首先,點擊"驗證設定"

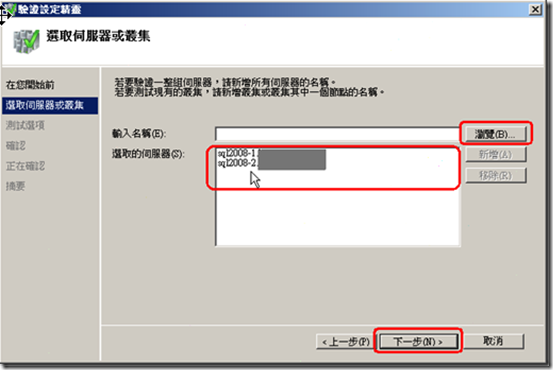

在此,將所有的Node選入。

讓系統知道是哪幾台Server要做叢集。

由於這都建置在AD中,因此在"瀏覽"中,選定Server Name的介面如同在選帳號一般,只是它是尋找Computer Object。

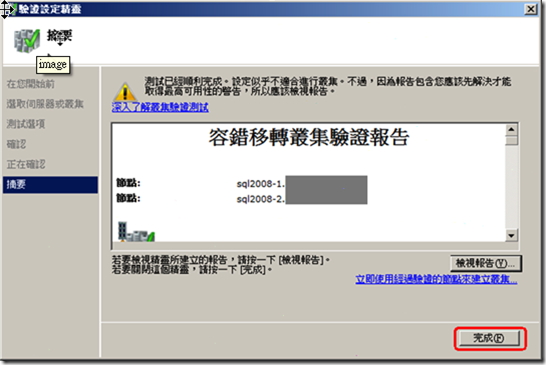

至此,驗證結束,可以點擊"檢視報告"去看測試細節。

本案例因為節點之間只有一個網路,有可能導致單點毀損,所以系統有出警告。

由於測試結果沒有問題,那我們準備進行正式建置。

P.S. 請用合適的帳號建立(本範例使用Domain Admin)

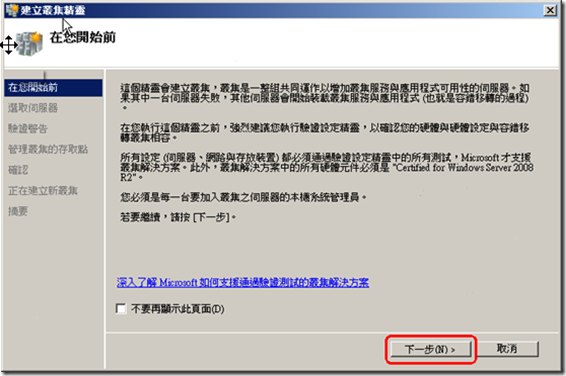

接下來,點擊"建立叢集"。

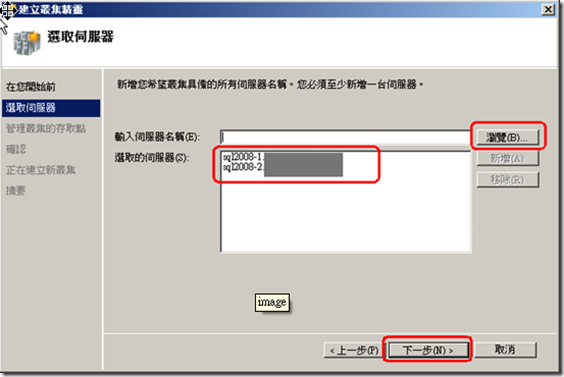

跟上面的"驗證設定"一樣的,要選取所有的Node Server。

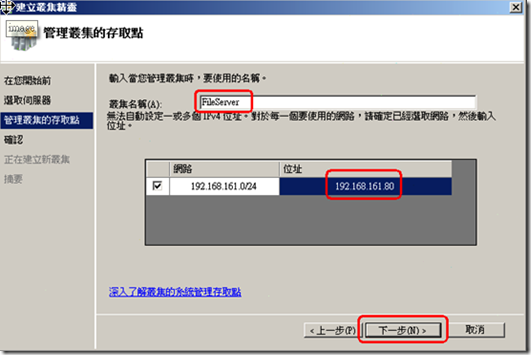

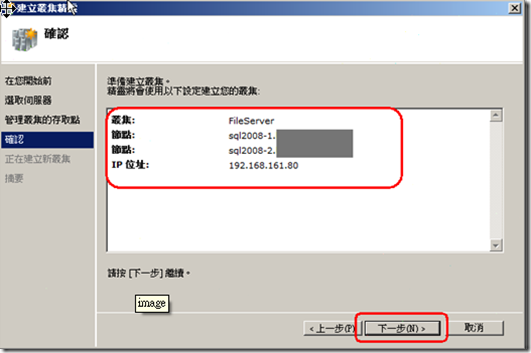

這邊是要輸入"叢集的名稱"與IP

由於一個叢集可以有多個服務,每個服務屆時都會有自己的"名稱" 與 "IP"。

P.S. 本案例這邊將"叢集的名稱"設定為"FileServer",這是服務的名稱,是個不好的命名。

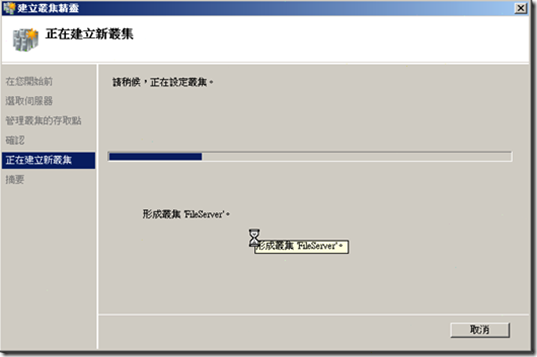

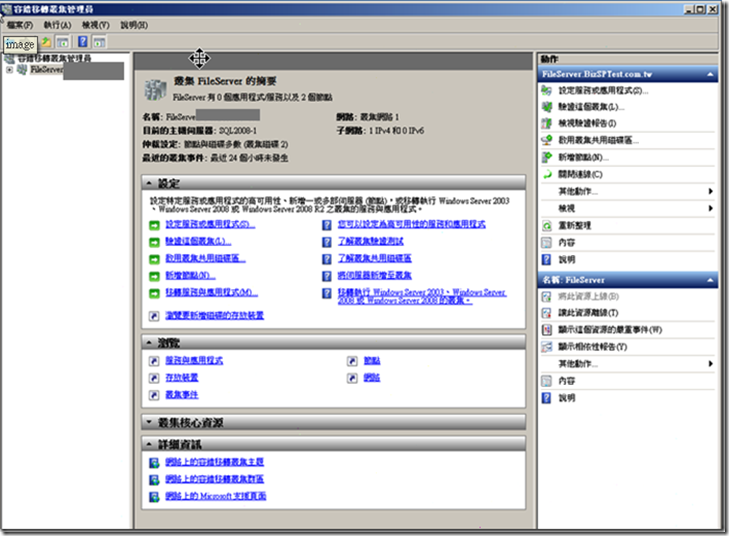

現在已經建置完成,各位可以發現左方的"容錯移轉叢集管理員"下方已出現我們所建置的叢集。

可以從左方,將我們所建立的叢集樹狀點開,看看內部的資訊。

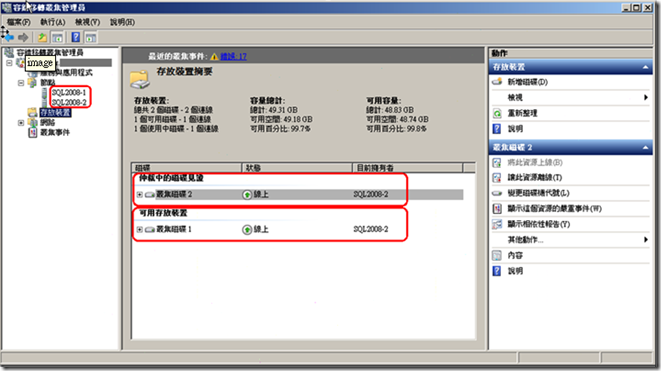

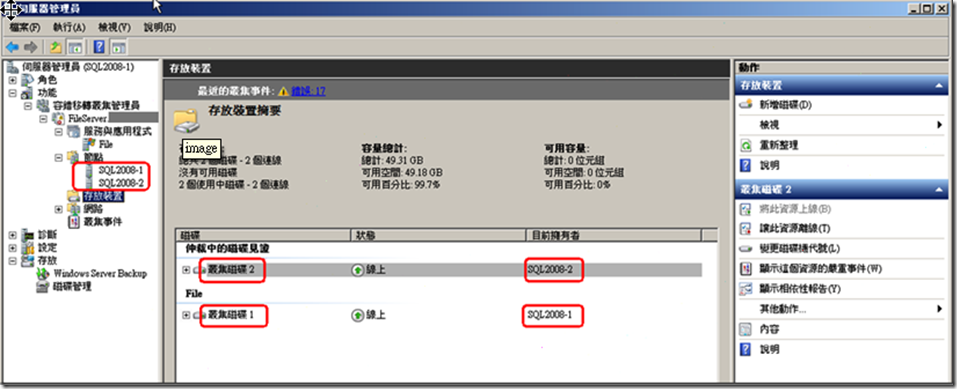

我們建立了兩個磁碟,一個是仲裁磁碟,叢集磁碟2,用來存放叢集組態的內容。

另一個是歸類於"可用存放裝置",叢集磁碟1,這是未來建立服務時要使用到的。

可以發現,我們的仲裁磁碟(叢集磁碟2)與叢集磁碟1目前的擁有者都是Node 2。

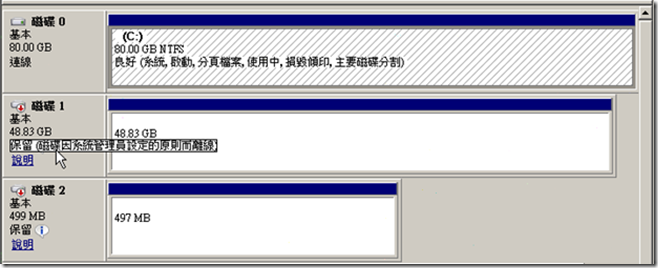

所以,讓我們登入Node 1去看,你會發現你看不到這兩顆磁碟。

再去"磁碟管理"去看看,你會發現這兩顆磁碟都在"保留"狀態,將游標移到上方會顯示"保留(磁碟音系統管理員的原則設定而離線"

5.建立服務

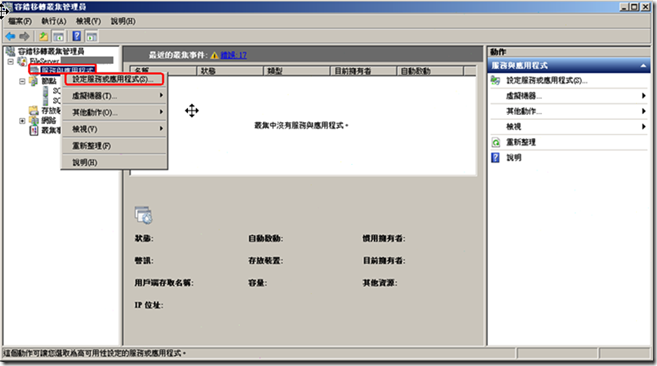

既然叢集以建立完成,那我們就開始在叢集上面建立服務。

本案例建立的是"檔案服務"。

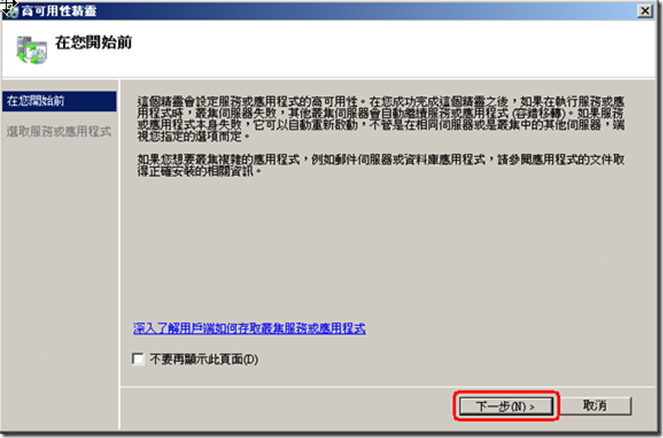

操作步驟如下顯示:

首先在左方的"服務與應用程式"上點擊右鍵,點擊"設定服務或應用程式"。

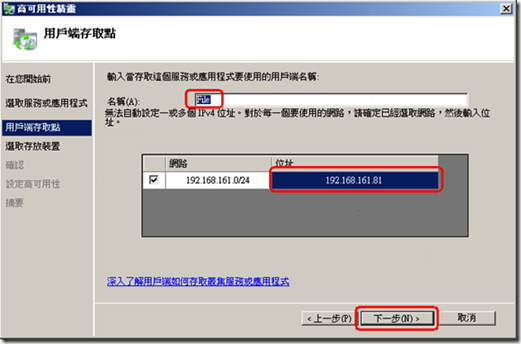

這邊要輸入該服務的"名稱"與"IP"。

以本範例而言,使用這可以使用\\File\ ,來存取檔案服務。

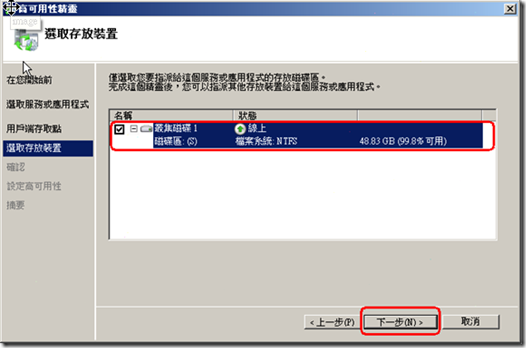

還記得剛剛叢集建立完成時,我們有做個確認,上面除了見證磁碟外,還有一個"可用存放裝置"下有一個" 叢集磁碟1"嗎?

這就是我們要使用的磁碟了。

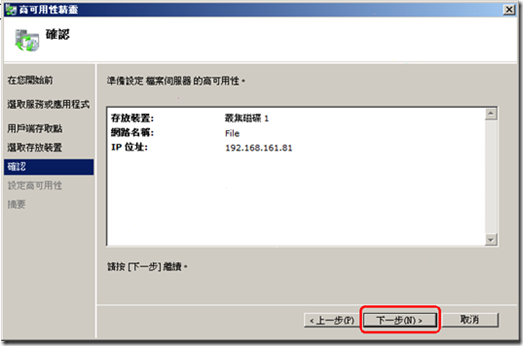

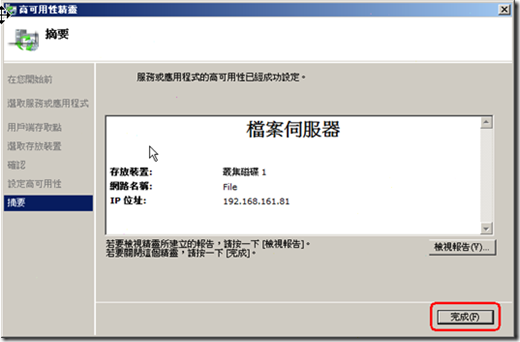

我們已經建立完成了。

可以看到服務器名稱: File

磁碟機:叢及磁碟1

6.設置對應的權限

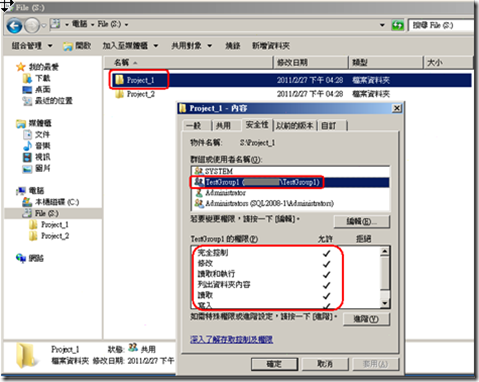

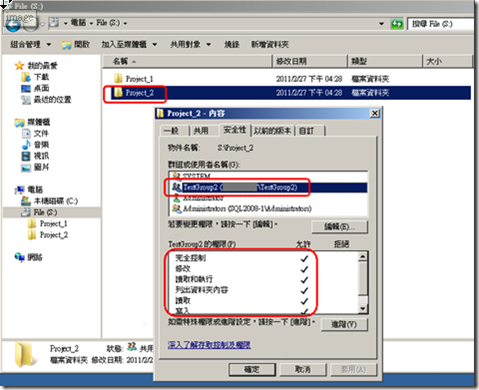

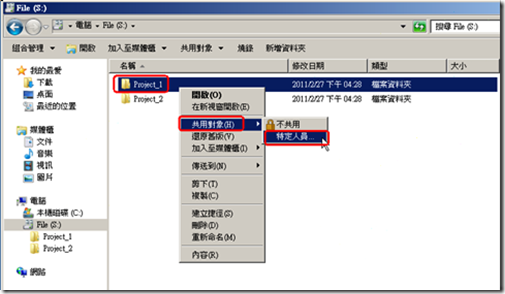

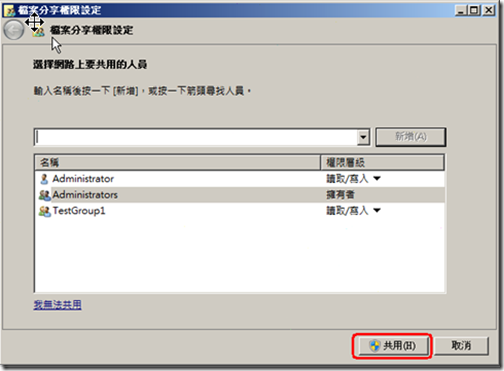

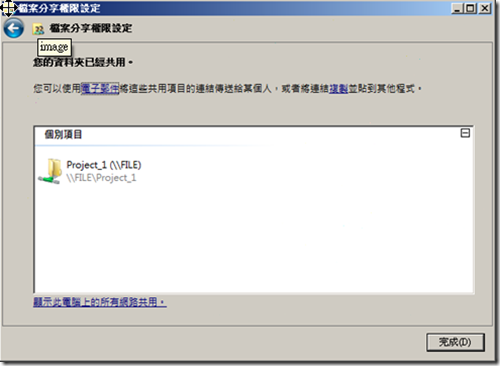

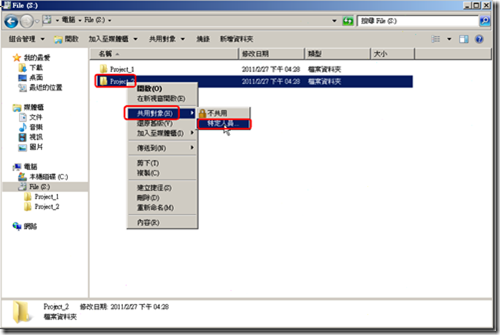

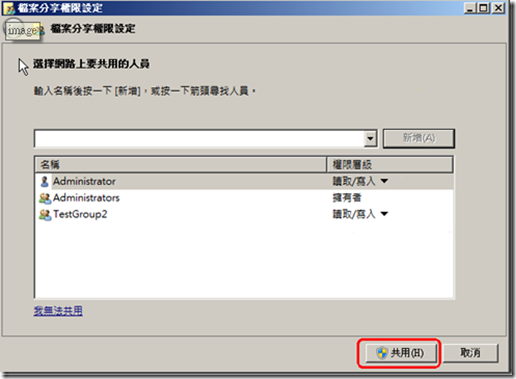

為了測試,我們將在File磁碟上建立兩個目錄"Project_1" 與 "Project_2",並分別授予"TestGroup1" 與 "TestGroup2"群組完全控制的權限。

相關設定如下,由於這是基本的作業,就不逐一介紹。

該圖片主要是讓各位看到設定內容而已。

各目錄權限設定

設定Project_1的共用。

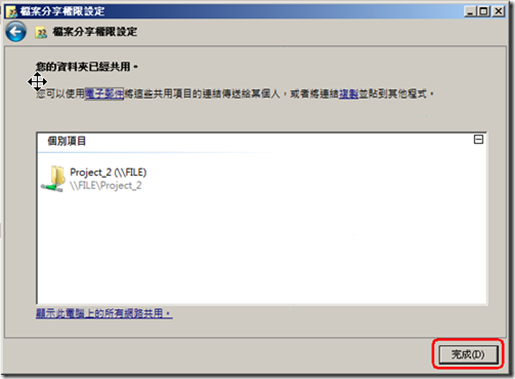

設定Project_2的共用。

6.測試

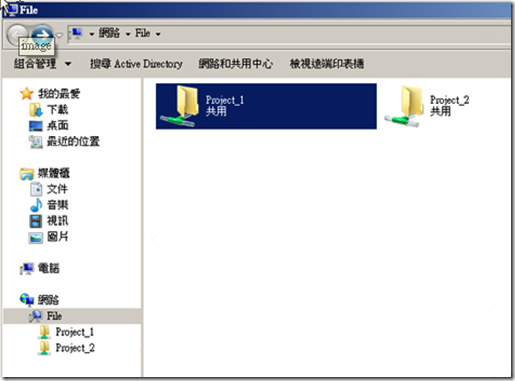

最後,讓我們來測試一下設定是否成功吧!

首先用Test1登入,然後進行權限測試。

以下是測試的過程,就不多做介紹了。

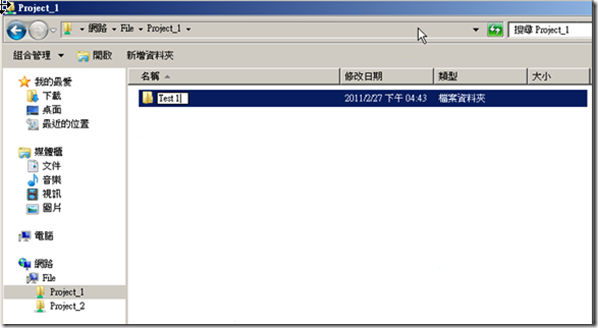

Test1針對Project_1擁有完全控制,因此可以建立子目錄。

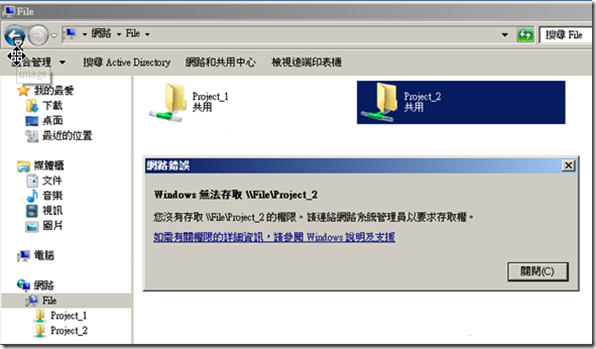

但對Project_2則無權限存取。

接下來測試的重點是"容錯移轉"。

首先登入Node 1,開啟"容錯移轉叢及管理員"。

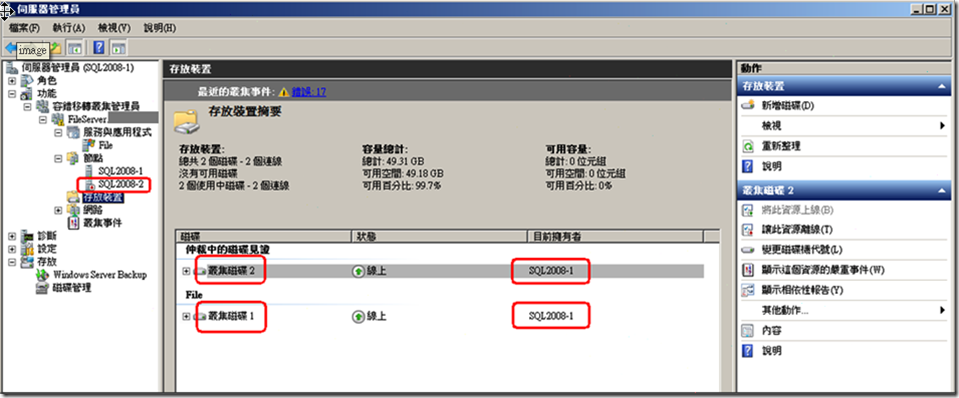

看看目前的存放裝置中,仲裁磁碟的擁有者是Node 2。

那我們將Node 2給關機,約過5秒鐘後,"仲裁磁碟"的擁有者改為Node 1。

且對Client端的服務也沒有中斷。

簡單的容錯測試也已完成。

7.相關資料補充

http://technet.microsoft.com/zh-tw/library/cc731002(WS.10).aspx

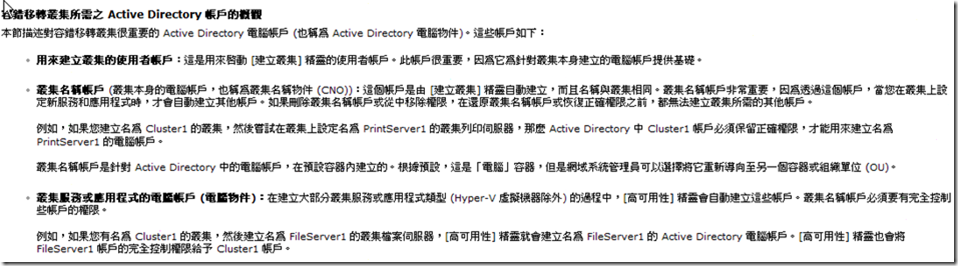

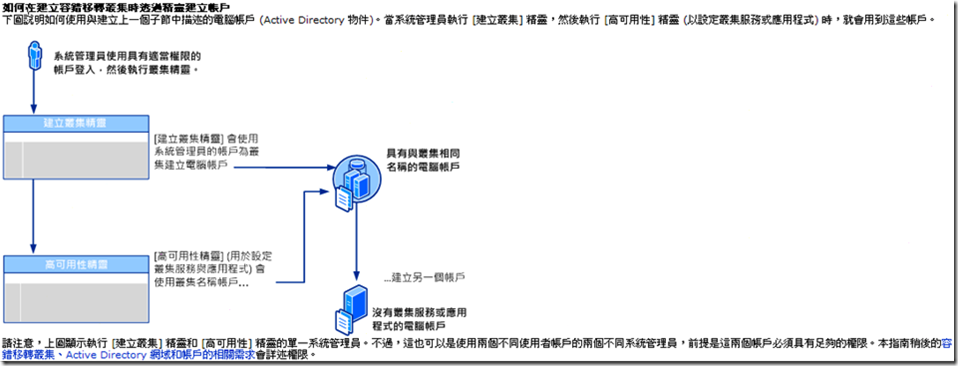

如果你的容錯叢集建立者非網域管理者,請參考以下文章中的"為叢集安裝人員設定帳戶的步驟",以建立出合乎要求的帳號權限。

http://technet.microsoft.com/zh-tw/library/cc731002(WS.10).aspx#BKMK_steps_installer

================================================================

以前電腦老師跟我說 : 這條路是一條不歸路。

十五年後,發現.....老師說對了!

以前電腦老師跟我說 : 不要把興趣當壓力。

十五年後,發現.....老師又說對了!

老師在講,我都沒在聽...... Orz